Récemment, Apple et Nvidia ont annoncé une collaboration visant à accélérer et à optimiser la vitesse d’inférence des grands modèles linguistiques (LLM).

Pour remédier aux inefficacités et à la bande passante mémoire limitée de l'inférence LLM autorégressive traditionnelle, les chercheurs en apprentissage automatique d'Apple ont publié et rendu open source une technique de décodage spéculatif appelée « ReDrafter » (Recurrent Draft Model) plus tôt en 2024.

Actuellement, ReDrafter a été intégré à la solution d'inférence évolutive « TensorRT-LLM » de Nvidia. Cette solution est une bibliothèque open source basée sur le framework de compilation d'apprentissage profond « TensorRT », spécialement conçue pour optimiser l'inférence LLM et prendre en charge les méthodes de décodage spéculatif comme « Medusa ».

Cependant, comme les algorithmes de ReDrafter utilisent des opérateurs jusqu'alors inutilisés, Nvidia a ajouté de nouveaux opérateurs ou rendu publics ceux existants, améliorant considérablement la capacité de TensorRT-LLM à s'adapter à des modèles complexes et à des méthodes de décodage.

Il est rapporté que ReDrafter accélère le processus d'inférence des grands modèles linguistiques (LLM) grâce à trois technologies clés :

- Modèle préliminaire RNN

- Algorithme d'attention dynamique des arbres

- Formation à la distillation des connaissances

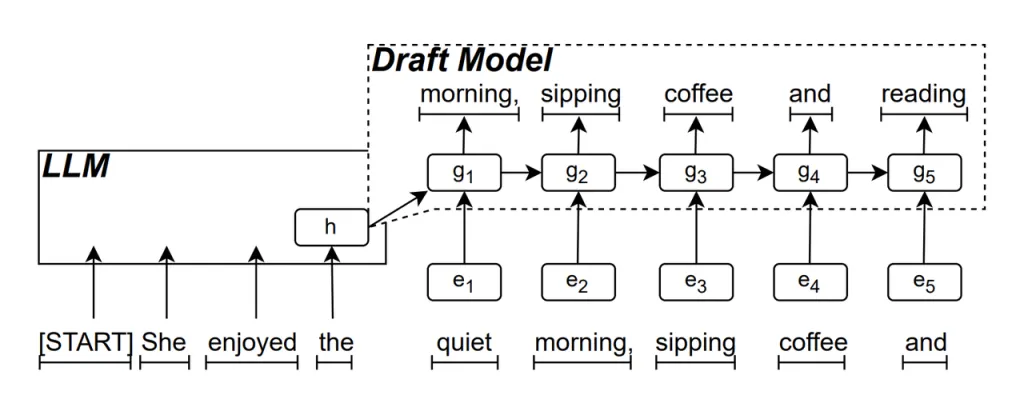

Modèle préliminaire RNN est la partie centrale de ReDrafter. Il utilise un réseau neuronal récurrent (RNN) pour prédire la prochaine séquence de mots possible en fonction des états cachés du LLM. Cela capture les dépendances temporelles et améliore la précision de la prédiction.

Le fonctionnement de ce modèle est le suivant : lorsque le LLM génère du texte, il génère d'abord un mot initial, puis le modèle RNN Draft utilise ce mot et l'état caché de la dernière couche du LLM comme entrée pour effectuer une recherche de faisceau, générant plusieurs séquences de mots candidats.

Contrairement aux LLM autorégressifs traditionnels qui génèrent un mot à la fois, ReDrafter peut générer plusieurs mots à chaque étape de décodage grâce aux prédictions du modèle RNN Draft, réduisant ainsi considérablement le nombre de fois où le LLM doit être appelé pour la validation, améliorant ainsi la vitesse d'inférence globale.

Algorithme d'attention dynamique des arbres est un algorithme qui optimise les résultats de la recherche de faisceau.

Au cours du processus de recherche de faisceaux, plusieurs séquences candidates sont générées, qui ont souvent le même début. L'algorithme Dynamic Tree Attention identifie ces débuts communs et les supprime des mots qui doivent être validés, réduisant ainsi la quantité de données que le LLM doit traiter.

Dans certains cas, cet algorithme peut réduire de 30 à 60 % le nombre de mots à valider. Cela signifie qu'avec l'algorithme Dynamic Tree Attention, ReDrafter peut utiliser les ressources informatiques plus efficacement, améliorant encore la vitesse d'inférence.

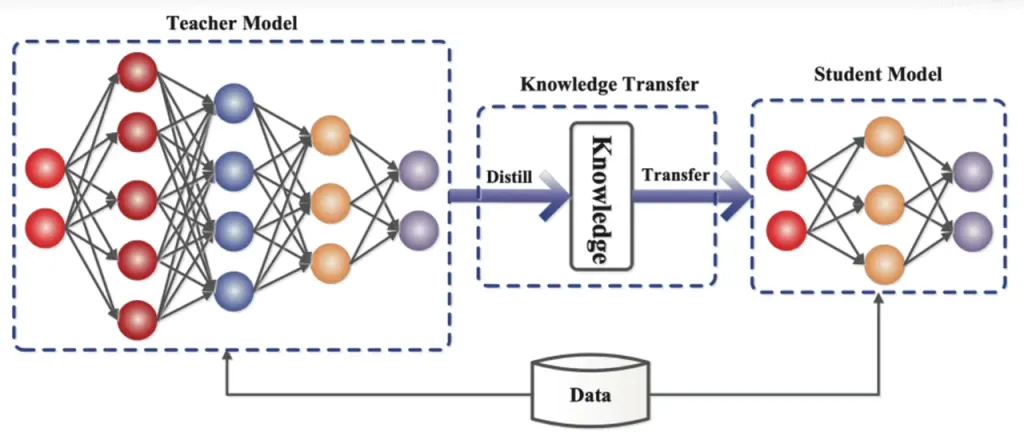

Distillation des connaissances est une technique de compression de modèle qui transfère les connaissances d'un modèle large et complexe (modèle de l'enseignant) vers un modèle plus petit et plus simple (modèle de l'étudiant). Dans ReDrafter, le modèle RNN Draft fait office de modèle de l'étudiant, apprenant du LLM (modèle de l'enseignant) par distillation des connaissances.

En détail, pendant le processus de formation par distillation, un grand modèle de langage (LLM) fournit une série de « distributions de probabilités » pour les prochains mots possibles. Les développeurs utilisent ces données de distribution de probabilité pour former un modèle de réseau neuronal récurrent (RNN), puis calculent la différence entre les distributions de probabilité des deux modèles et minimisent cette différence grâce à des algorithmes d'optimisation.

Au cours de ce processus, le modèle de projet RNN apprend en permanence les modèles de prédiction de probabilité du LLM, ce qui lui permet de générer un texte similaire au LLM dans des applications pratiques.

Grâce à l'entraînement par distillation des connaissances, le modèle RNN capture mieux les règles et les modèles de langage, prédisant ainsi avec plus de précision le résultat du LLM. En raison de sa taille plus petite et de son coût de calcul plus faible, il améliore considérablement les performances globales de ReDrafter dans des conditions matérielles limitées.

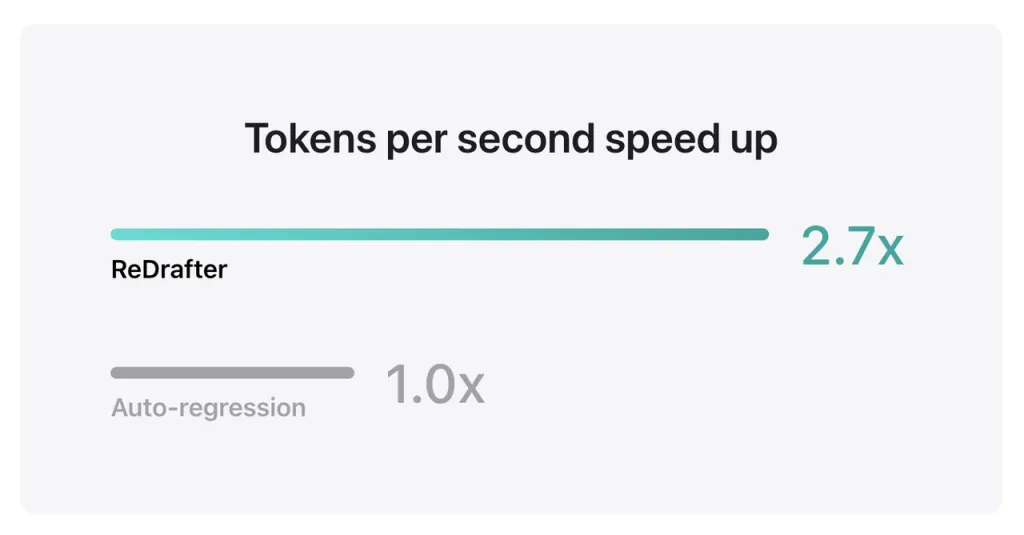

Les résultats de référence d'Apple montrent qu'en utilisant le modèle de production avec des milliards de paramètres intégrés à TensorRT-LLM de ReDrafter sur le GPU NVIDIA H100, le nombre de jetons générés par seconde par Greedy Decoding a augmenté de 2.7 fois.

De plus, sur le GPU M2 Ultra Metal d'Apple, ReDrafter a obtenu une amélioration de la vitesse d'inférence de 2.3 fois. Les chercheurs d'Apple ont déclaré : « Les LLM étant de plus en plus utilisés pour piloter des applications de production, l'amélioration de l'efficacité de l'inférence peut avoir un impact sur les coûts de calcul et réduire la latence côté utilisateur. »

Il convient de noter que tout en maintenant la qualité de sortie, ReDrafter réduit la demande de ressources GPU, permettant aux LLM de fonctionner efficacement même dans des environnements aux ressources limitées, offrant de nouvelles possibilités d'utilisation des LLM sur diverses plates-formes matérielles.

Apple a déjà ouvert le code source de cette technologie sur GitHub, et à l'avenir, les entreprises qui en bénéficieront incluront probablement plus que NVIDIA.

Source à partir de si un

Avis de non-responsabilité : les informations présentées ci-dessus sont fournies par ifanr.com, indépendamment d'Chovm.com. Chovm.com ne fait aucune représentation ni garantie quant à la qualité et à la fiabilité du vendeur et des produits. Chovm.com décline expressément toute responsabilité en cas de violations des droits d'auteur du contenu.

বাংলা

বাংলা Nederlands

Nederlands English

English Français

Français Deutsch

Deutsch हिन्दी

हिन्दी Bahasa Indonesia

Bahasa Indonesia Italiano

Italiano 日本語

日本語 한국어

한국어 Bahasa Melayu

Bahasa Melayu മലയാളം

മലയാളം پښتو

پښتو فارسی

فارسی Polski

Polski Português

Português Русский

Русский Español

Español Kiswahili

Kiswahili ไทย

ไทย Türkçe

Türkçe اردو

اردو Tiếng Việt

Tiếng Việt isiXhosa

isiXhosa Zulu

Zulu